Urządzenia przetwarzające ewolucję, rodzaje, przykłady

Plik urządzenia do przetwarzania komputer to jednostki, które odgrywają ważną rolę w operacjach procesowych komputera. Służą do przetwarzania danych zgodnie z instrukcjami programu.

Przetwarzanie jest najważniejszą funkcją komputera, ponieważ w tej fazie dokonywana jest transformacja danych w użyteczne informacje przy użyciu wielu komputerowych urządzeń przetwarzających..

Główną funkcją urządzeń przetwarzających jest odpowiedzialność za uzyskanie wymownych informacji z danych, które są przekształcane za pomocą kilku z tych urządzeń..

Przetwarzanie audio i wideo polega na oczyszczeniu danych w taki sposób, aby były przyjemniejsze dla ucha i dla oczu, nadając im bardziej realistyczny wygląd.

Dlatego widać to lepiej w przypadku niektórych kart graficznych niż innych, ponieważ karta wideo przetwarza dane w celu zwiększenia realizmu. To samo dzieje się z kartami dźwiękowymi i jakością dźwięku.

Indeks artykułów

- 1 procesor

- 2 Ewolucja od początku do chwili obecnej

- 2.1 Etap początkowy

- 2.2 Przekaźniki i lampy próżniowe

- 2.3 Tranzystory

- 2.4 Układy scalone

- 2.5 Mikroprocesor

- 3 rodzaje

- 3.1 Wielordzeniowe urządzenia przetwarzające

- 3.2 Mobilne urządzenia przetwarzające

- 3.3 Procesor graficzny (GPU)

- 4 Przykłady

- 4.1 - Jednostka centralna (CPU)

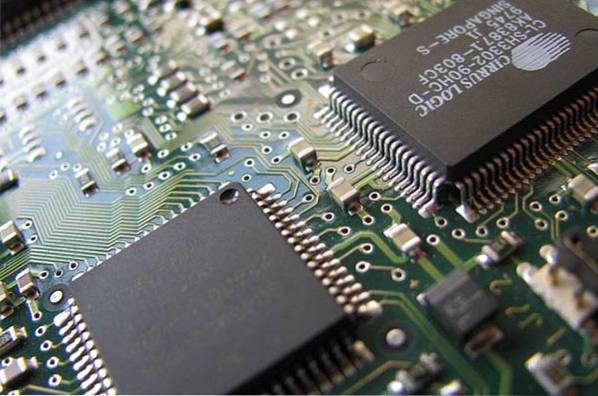

- 4.2 - Płyta główna

- 4.3 - Chip

- 4.4 - Zegar

- 4.5 - Gniazdo rozszerzeń

- 4.6 - Magistrala danych

- 4.7 - Magistrala sterująca

- 4.8 - Karta graficzna

- 4.9 - Jednostka przetwarzania grafiki (GPU)

- 4.10 - Karta interfejsu sieciowego (NIC)

- 4.11 - Karta sieci bezprzewodowej

- 4.12 - Karta dźwiękowa

- 4.13 - Kontroler pamięci masowej

- 5 Referencje

Edytor

Ilekroć informacja dociera do komputera z urządzenia wejściowego, takiego jak klawiatura, informacje te muszą przejść ścieżkę pośrednią, zanim zostaną przydzielone do urządzenia wyjściowego, takiego jak monitor..

Urządzenie przetwarzające to dowolne urządzenie lub instrument w komputerze, które jest odpowiedzialne za zarządzanie tą ścieżką pośrednią. Obsługują funkcje, wykonują różne obliczenia, a także sterują innymi urządzeniami sprzętowymi.

Urządzenia przetwarzające dokonują konwersji między różnymi typami danych, a także manipulują danymi i wykonują z nimi zadania.

Zwykle termin CPU odnosi się do procesora, a dokładniej do jego jednostki obliczeniowej i jednostki sterującej, tym samym odróżniając te elementy od zewnętrznych komponentów komputera, takich jak pamięć główna i obwody wejścia / wyjścia..

Procesor ściśle współpracuje z pamięcią główną i peryferyjnymi urządzeniami magazynującymi.

Mogą istnieć inne systemy i urządzenia peryferyjne, które pomagają gromadzić, przechowywać i rozpowszechniać dane, ale zadania przetwarzania są unikalne dla procesora..

Ewolucja od pierwszego do współczesności

Etap początkowy

Wczesne komputery, takie jak ENIAC, wymagały fizycznego okablowania za każdym razem, gdy wykonywano inne zadanie.

W 1945 roku matematyk von Neumann rozprowadził szkic do komputera z zapisanym programem, zwanego EDVAC, który ostatecznie został ukończony w 1949 roku..

Pierwsze urządzenia, które można było właściwie nazwać procesorami, pojawiły się wraz z pojawieniem się tego komputera z zapisanym programem.

Programy stworzone dla EDVAC były przechowywane w pamięci głównej komputera, a nie musiały być ustanawiane poprzez okablowanie komputera.

Dlatego program, który działał EDVAC, można było zamienić za pomocą prostej zmiany zawartości pamięci.

Pierwsze procesory były unikalnymi projektami, które były używane w określonym komputerze. Następnie ta metoda indywidualnego projektowania procesorów dla konkretnej aplikacji umożliwiła tworzenie wielozadaniowych procesorów w dużej liczbie..

Przekaźniki i lampy próżniowe

Były powszechnie używane jako urządzenia przełączające. Komputer potrzebował tysięcy takich urządzeń. Komputery lampowe, takie jak EDVAC, ulegały awarii średnio co osiem godzin.

W końcu procesory oparte na lampach stały się niezbędne, ponieważ korzyści wynikające z posiadania znacznej prędkości przeważyły nad problemem z niezawodnością..

Te wczesne synchroniczne procesory działały z niską częstotliwością taktowania w porównaniu z obecnymi konstrukcjami mikroelektronicznymi, głównie z powodu niskiej prędkości elementów przełączających użytych do ich produkcji..

Tranzystory

W latach pięćdziesiątych i sześćdziesiątych XX wieku procesory nie musiały już być budowane w oparciu o urządzenia przełączające tak duże i ulegające awarii, jak i kruche, takie jak przekaźniki i lampy próżniowe..

Ponieważ różne technologie umożliwiły produkcję mniejszych i bardziej niezawodnych urządzeń elektronicznych, wzrosła również złożoność konstrukcji procesora. Pierwszą poprawę tego typu osiągnięto wraz z pojawieniem się tranzystora.

Dzięki temu postępowi możliwe było wykonanie procesorów o większej złożoności, które zawiodły znacznie mniej w jednej lub kilku płytkach drukowanych. Komputery oparte na tranzystorach oferowały szereg ulepszeń w stosunku do poprzednich.

Oprócz oferowania niższego zużycia energii i większej niezawodności, tranzystory umożliwiły procesorom szybszą pracę dzięki krótkiemu czasowi przełączania, jaki miał tranzystor w porównaniu z lampą próżniową..

Układy scalone

Tranzystor MOS został wynaleziony przez Bell Labs w 1959 roku. Charakteryzuje się wysoką skalowalnością, a ponadto zużywa znacznie mniej energii elektrycznej i jest znacznie bardziej skondensowany niż tranzystory bipolarne. Umożliwiło to zbudowanie układów scalonych o dużej gęstości.

W ten sposób opracowano metodę wytwarzania wielu połączonych ze sobą tranzystorów na niewielkiej powierzchni. Układ scalony pozwolił na wyprodukowanie dużej liczby tranzystorów w jednej formie lub „chipie” opartym na półprzewodnikach..

Standaryzacja rozpoczęła się na etapie makrokomputerów tranzystorowych i minikomputerów i przyspieszyła dramatycznie wraz z rozpowszechnieniem się układu scalonego, umożliwiając projektowanie i wytwarzanie coraz bardziej złożonych procesorów..

Wraz z postępem technologii mikroelektronicznej można było umieścić więcej tranzystorów w układach scalonych, zmniejszając w ten sposób liczbę układów scalonych wymaganych do skompletowania procesora..

Układy scalone zwiększyły liczbę tranzystorów do setek, a później do tysięcy. Do 1968 roku liczba układów scalonych potrzebnych do zbudowania kompletnego procesora została zmniejszona do 24, z których każdy zawierał około 1000 tranzystorów MOS..

Mikroprocesor

Przed pojawieniem się dzisiejszych mikroprocesorów komputery wykorzystywały wiele coraz mniejszych układów scalonych, które były rozproszone po całej płytce drukowanej..

Procesor w dzisiejszej postaci został po raz pierwszy opracowany w 1971 roku przez firmę Intel do pracy w ramach komputerów osobistych..

Pierwszym mikroprocesorem był 4-bitowy procesor o nazwie Intel 4004. Został on następnie zastąpiony przez nowsze konstrukcje z architekturą 8-bitową, 16-bitową, 32-bitową i 64-bitową..

Mikroprocesor to układ scalony wykonany z krzemowego materiału półprzewodnikowego, w którym znajdują się miliony komponentów elektrycznych..

W końcu stał się centralnym procesorem dla komputerów czwartej generacji z lat 80. i późniejszych dziesięcioleci..

Nowoczesne mikroprocesory pojawiają się w urządzeniach elektronicznych, od samochodów po telefony komórkowe, a nawet w zabawkach.

Rodzaje

Wcześniej procesory komputerowe używały liczb do identyfikacji, pomagając w ten sposób zidentyfikować najszybsze procesory. Na przykład procesor Intel 80386 (386) był szybszy niż procesor 80286 (286).

Po wejściu na rynek procesora Intel Pentium, który logicznie powinien nazywać się 80586, inne procesory zaczęły nosić nazwy takie jak Celeron i Athlon.

Obecnie oprócz różnych nazw procesorów istnieją różne pojemności, szybkości i architektury (32-bitowe i 64-bitowe).

Wielordzeniowe urządzenia przetwarzające

Pomimo rosnących ograniczeń wielkości chipów, chęć wytwarzania większej mocy z nowych procesorów nadal motywuje producentów..

Jedną z tych innowacji było wprowadzenie wielordzeniowego procesora, pojedynczego mikroprocesora, który może mieć procesor wielordzeniowy. W 2005 roku Intel i AMD wypuściły prototypowe chipy z projektami wielordzeniowymi.

Pentium D Intela był dwurdzeniowym procesorem, który porównano z dwurdzeniowym procesorem AMD Athlon X2, układem przeznaczonym do serwerów z najwyższej półki..

To był jednak dopiero początek rewolucyjnych trendów w chipach mikroprocesorowych. W następnych latach procesory wielordzeniowe ewoluowały od układów dwurdzeniowych, takich jak Intel Core 2 Duo, do dziesięciordzeniowych, takich jak Intel Xion E7-2850..

Ogólnie rzecz biorąc, procesory wielordzeniowe oferują więcej niż tylko podstawy procesora jednordzeniowego i są zdolne do pracy wielozadaniowej i wieloprocesowej, nawet w ramach indywidualnych aplikacji..

Mobilne urządzenia przetwarzające

Podczas gdy tradycyjne mikroprocesory stosowane zarówno w komputerach osobistych, jak i superkomputerach przeszły ogromną ewolucję, branża komputerów przenośnych szybko się rozwija i stawia czoła własnym wyzwaniom..

Producenci mikroprocesorów integrują wszelkiego rodzaju funkcje, aby zwiększyć indywidualne wrażenia.

Równowaga między większą prędkością a kontrolowaniem ciepła pozostaje bólem głowy, nie wspominając o wpływie tych szybszych procesorów na mobilne akumulatory..

Jednostka przetwarzania grafiki (GPU)

Procesor graficzny wykonuje również obliczenia matematyczne, tylko tym razem, preferując obrazy, filmy i inne rodzaje grafiki.

Zadania te były wcześniej obsługiwane przez mikroprocesor, ale gdy aplikacje CAD intensywnie korzystające z grafiki stały się powszechne, pojawiło się zapotrzebowanie na dedykowany sprzęt przetwarzający, zdolny do obsługi takich zadań bez wpływu na ogólną wydajność komputera..

Typowy procesor graficzny ma trzy różne formy. Zwykle jest podłączony osobno do płyty głównej. Jest zintegrowany z procesorem lub jest dostarczany jako oddzielny dodatkowy układ na płycie głównej. Procesor graficzny jest dostępny dla komputerów stacjonarnych, laptopów, a także komputerów przenośnych.

Intel i Nvidia to wiodące chipsety graficzne na rynku, przy czym ten ostatni jest preferowanym wyborem do głównego przetwarzania grafiki..

Przykłady

- Centralna jednostka przetwarzania (CPU)

Najważniejsze urządzenie przetwarzające w systemie komputerowym. Nazywany także mikroprocesorem.

Jest to wewnętrzny układ komputera, który przetwarza wszystkie operacje, które otrzymuje z urządzeń i aplikacji uruchomionych na komputerze..

Intel 8080

Wprowadzony w 1974 roku, miał 8-bitową architekturę, 6000 tranzystorów, prędkość 2 MHz, dostęp do 64 kb pamięci i 10-krotnie większą wydajność niż 8008..

Intel 8086

Wprowadzony w 1978 roku. Używał architektury 16-bitowej. Miał 29 000 tranzystorów, pracujących z prędkością od 5 MHz do 10 MHz. Może uzyskać dostęp do 1 megabajta pamięci.

Intel 80286

Został wprowadzony na rynek w 1982 roku. Miał 134 000 tranzystorów, pracujących z częstotliwością zegara od 4 MHz do 12 MHz. Pierwszy procesor zgodny z poprzednimi procesorami.

Pentium

Wprowadzone przez firmę Intel w 1993 roku. Mogą być używane z prędkościami od 60 MHz do 300 MHz. Kiedy został wydany, miał prawie dwa miliony więcej tranzystorów niż procesor 80486DX z 64-bitową magistralą danych..

Core Duo

Pierwszy dwurdzeniowy procesor Intela opracowany dla komputerów przenośnych, wprowadzony na rynek w 2006 roku. Był to również pierwszy procesor Intela używany w komputerach Apple..

Intel Core i7

Jest to seria procesorów obejmująca 8 generacji chipów Intela. Posiada 4 lub 6 rdzeni o szybkości od 2,6 do 3,7 GHz i został wprowadzony w 2008 roku.

- Płyta główna

Wyznaczona również płyta główna. Jest to największa płytka wewnątrz komputera. Mieści procesor, pamięć, magistrale i wszystkie inne elementy.

Przydziela moc i zapewnia sposób komunikacji dla wszystkich elementów sprzętowych, aby komunikować się ze sobą.

- Żeton

Grupa współpracujących ze sobą układów scalonych obsługujących i sterujących całym systemem komputerowym. W ten sposób zarządza przepływem danych w całym systemie.

- Zegar

Służy do nadążania za wszystkimi obliczeniami komputera. Zapewnia, że wszystkie obwody w komputerze mogą ze sobą współpracować.

- Gniazdo rozszerzeń

Gniazdo znajdujące się na płycie głównej. Służy do podłączenia karty rozszerzeń, zapewniając w ten sposób komplementarne funkcje dla komputera, takie jak wideo, audio, pamięć itp..

- Magistrala danych

Zestaw kabli, których procesor używa do przesyłania informacji między wszystkimi elementami systemu komputerowego.

- Magistrala adresowa

Zestaw kabli przewodzących, które przenoszą tylko adresy. Informacje przepływają z mikroprocesora do pamięci lub do urządzeń wejścia / wyjścia.

- Magistrala sterująca

Przenosi sygnały, które informują o stanie różnych urządzeń. Zwykle magistrala sterująca ma tylko jeden adres.

- Karta graficzna

Karta rozszerzeń umieszczana na płycie głównej komputera. Zajmuje się obróbką obrazu i wideo. Służy do tworzenia obrazu na ekranie.

- Jednostka przetwarzania grafiki (GPU)

Układ elektroniczny przeznaczony do zarządzania pamięcią w celu przyspieszenia tworzenia obrazów przeznaczonych do emisji na urządzeniu wyświetlającym.

Różnica między GPU a kartą graficzną jest podobna do różnicy między procesorem a płytą główną.

- Karta sieciowa (NIC)

Karta rozszerzeń używana do łączenia się z dowolną siecią, a nawet Internetem za pomocą kabla ze złączem RJ-45.

Karty te mogą komunikować się ze sobą za pośrednictwem przełącznika sieciowego lub jeśli są bezpośrednio połączone.

- Karta bezprzewodowa

Prawie wszystkie nowoczesne komputery mają interfejs do łączenia się z siecią bezprzewodową (Wi-Fi), która jest wbudowana bezpośrednio w płytę główną..

- Karta dźwiękowa

Karta rozszerzeń używana do odtwarzania dowolnego rodzaju dźwięku na komputerze, który można usłyszeć przez głośniki.

Dołączone do komputera, w gnieździe rozszerzeń lub zintegrowane z płytą główną.

- Kontroler pamięci masowej

Obsługuje przechowywanie i odzyskiwanie danych, które są trwale przechowywane na dysku twardym lub podobnym urządzeniu. Posiada własny wyspecjalizowany procesor do wykonywania tych operacji.

Bibliografia

- Nadzieja na komputer (2018). Urządzenie przetwarzające. Zaczerpnięte z: computerhope.com.

- Am7s (2019). Co to są komputerowe urządzenia przetwarzające? Zaczerpnięte z: am7s.com.

- Salomon (2018). Rodzaje sprzętu komputerowego - urządzenia przetwarzające. Zig Link IT. Zaczerpnięte z: ziglinkit.com.

- Hub Pages (2019). Urządzenia do przetwarzania danych. Zaczerpnięte z: hubpages.com.

- Wikipedia, wolna encyklopedia (2019). Jednostka centralna. Zaczerpnięte z: en.wikipedia.org.

- Nadzieja na komputer (2019). PROCESOR. Zaczerpnięte z: computerhope.com.

- Margaret Rouse (2019). Procesor (CPU). Techtarget. Zaczerpnięte z: whatis.techtarget.com.

Jeszcze bez komentarzy